Au centre de deux séminaires « Evaluation » : la démarche d’évaluation mise en place par Prospective Jeunesse dans le cadre de son offre de formation-accompagnement. Une opportunité pour les participants de découvrir un cas concret et de travailler sur des données qualitatives collectées six mois après la formation.

Depuis mai 2019, ESPRIst-ULiège organise des séminaires « évaluation » à destination des acteurs intervenant dans le champ de la santé et de ses déterminants sociaux en Région wallonne. Ces rencontres suscitent l’intérêt de participants issus de secteurs variés et actifs en promotion de la santé, dans un milieu de vie particulier ou de manière transversale.

Le but ultime poursuivi par ESPRIst-ULiège est de susciter l’intérêt pour l’évaluation participative et négociée. Pour ce faire, la méthodologie associe des présentations de cas concrets et des cadrages théoriques et méthodologiques. Au fil des rencontres émergent des balises essentielles à tout projet d’évaluation.

En 2020, plusieurs séminaires ont été organisés en présentiel et en virtuel. En mars, une première séance a repositionné les repères théoriques et méthodologiques de l’évaluation participative et négociée abordés l’année précédente. C’est à l’automne que se sont tenus deux séminaires organisés en collaboration avec Prospective Jeunesse.

Dans cet article, nous entendons disséminer davantage les réflexions sur ce cas précis dans lequel les acteurs de promotion de la santé pourront trouver un écho utile pour développer leurs pratiques d’évaluation.

Qui est Prospective Jeunesse?

Prospective Jeunesse (PJ) est un centre d’étude et de formation, fondé en 1978 et subventionné par le Service public francophone bruxellois et l’AViQ. PJ dispose d’une grande expérience dans l’accompagnement des adultes, relais des jeunes, et dans la prévention des consommations problématiques et des dépendances aux produits psychotropes ou aux écrans chez les jeunes. Les activités de PJ s’articulent autour de trois axes :

- L’information et la sensibilisation via la parution d’une revue trimestrielle traitant de thématiques pointues en lien avec les consommations.

- Les consultations psychologiques à destination de consommateur.trice.s et/ou leurs proches.

- Les formations et accompagnements qui se réalisent principalement avec les adultes, au départ de demandes reçues, et qui permettent, entre autres, de travailler à la cohérence interne d’une équipe, à la posture à adopter face aux consommations problématiques, mais aussi à la prise en compte de la parole des jeunes. Les publics sont principalement les écoles ou encore le secteur de l’Aide à la jeunesse. L’objectif est de réunir le maximum de personnes autour d’un projet commun, depuis les encadrants jusqu’à la direction, en passant par les jeunes. Certaines formations sont programmées, tandis que d’autres peuvent être données à la demande. Elles se veulent participatives et interactives.

Pour en savoir plus sur les missions et activités de Prospective Jeunesse : https://prospective-jeunesse.be/

Un dispositif d’évaluation à 6 mois

Comme d’autres acteurs en promotion de la santé, PJ a entamé une réflexion sur l’évaluation de ses projets et plus particulièrement des accompagnements et des formations sur mesure. Le but poursuivi est d’avoir un aperçu sur l’appropriation de ce qui a été vu et vécu en formation (changements d’attitude, culture institutionnelle enrichie, se sentir plus à l’aise pour parler des consommations, etc.), et également de porter un regard sur le chemin parcouru pour éventuellement identifier de nouveaux besoins ou pistes d’action.

Dans un premier temps, ce dispositif d’évaluation à 6 mois n’était pas formalisé ; il s’agissait plutôt d’un retour d’expériences et d’une manière d’inviter les participants à garder un lien avec la formation. Ensuite, ce dispositif a été construit et intégré à la formation comme module à part entière. Ainsi, dès le début de la formation, les participants sont informés du déroulement de cette rencontre, six mois après la formation.

Le module d’évaluation a été construit sur base de la méthode des Chapeaux d’Edouard De Bono. Les chapeaux de couleurs différentes invitent la personne à sortir de son raisonnement habituel en passant par différents modes de pensées : le factuel, l’émotionnel, le prospectif, etc. Cette méthode a montré des résultats intéressants dans le cadre de ce dispositif, permettant aux participants de réfléchir, six mois plus tard, aux apports de la formation et de se rendre compte, parfois, qu’ils ont déjà avancé sur ces problématiques de consommations et de dépendances, que le changement demande du temps et nécessite de mobiliser les ressources de l’institution.

Rapidement a émergé la question du traitement de ces données « vivantes » issues de ce module d’évaluation. C’est l’étape à laquelle PJ est arrivée à présent. Comment formaliser ces résultats, afin de faire évoluer les pratiques des intervenants, mais aussi de les faire remonter vers les pouvoirs subsidiants qui ont des canevas d’évaluation en décalage avec les pratiques de la seconde ligne? Comment se saisir pleinement de ces données et construire quelque chose de solide ? C’est à cette réflexion que le séminaire évaluation de ESPRIst-ULiège entendait contribuer au travers des ateliers et des échanges entre participants issus de secteurs et de niveaux institutionnels divers.

Un séminaire évaluation ancré dans la pratique

En 2019, ESPRIst-ULiège invitait les participants aux séminaires à soumettre un cas concret d’évaluation pour de futurs séminaires. C’est ainsi qu’a été construit, en collaboration avec Prospective Jeunesse (PJ), le séminaire : « Objets, critères et indicateurs ; comment les construire et les identifier au départ des données collectées sur le terrain ? »

Après avoir découvert la démarche d’évaluation mise en place par PJ les participants ont travaillé sur des données qualitatives collectées lors de séances d’évaluation à 6 mois. Ces données sont présentées dans des tableaux où chaque colonne correspond à un chapeau de De Bono :

- Blanc : Les faits : Ce dont on se souvient.

- Rouge : Les émotions : Comment on se sent à ce stade par rapport à sa pratique.

- Jaune : La critique positive : Ce qu’on a mobilisé et qui a bien fonctionné.

- Noir : La critique négative : Ce qui n’a pas bien fonctionnée ou qui a manqué.

- Vert : La créativité : Ce qu’on pourrait mettre en place aujourd’hui.

- Bleu : La neutralité : Ce qui ressort de cette session à 6 mois.

Un glossaire accompagnait chaque tableau afin de permettre aux participants de comprendre les outils et concepts particuliers auxquels les participants aux formations font référence lors de la session.

Faire émerger les objets d’évaluation au départ d’un matériau collecté sur le terrain

L’exercice proposé lors des ateliers du 18 septembre, différentes facettes de l’évaluation ont été évoquées : les finalités, les questions évaluatives et les objets.

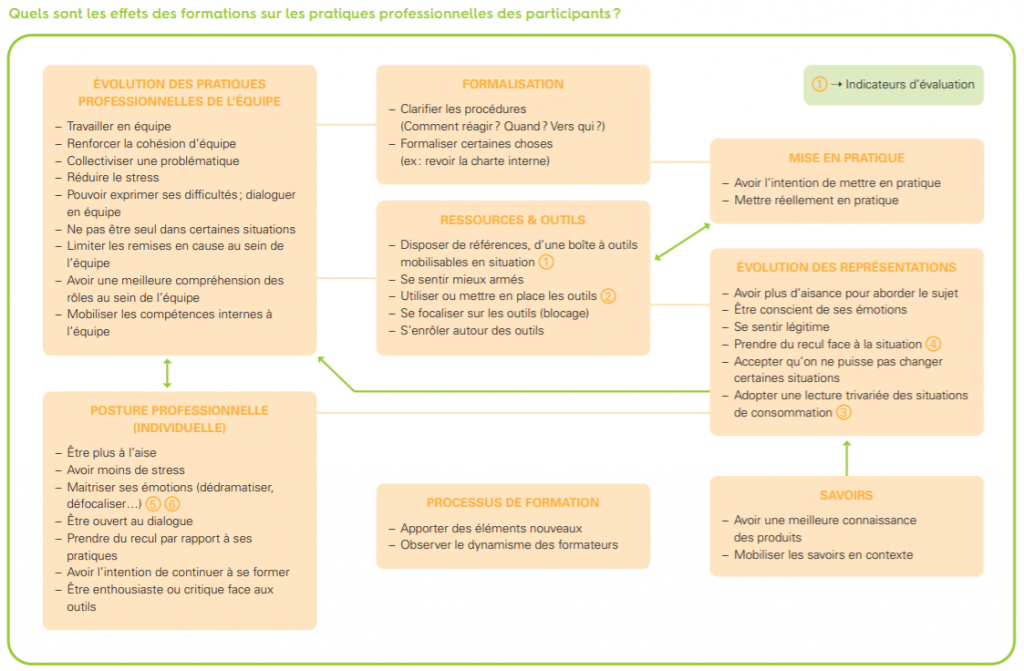

Le point de départ est une question évaluative formulée par l’équipe de PJ « Quels sont les effets des formations sur les pratiques professionnelles des participants ? »

L’équipe de PJ a présenté ses activités et ses options méthodologiques ainsi que son dispositif de formation-accompagnement et d’évaluation. Deux ateliers ont été organisés. Dans chaque atelier, les données qualitatives sont présentées de façon identique, mais portent sur des interventions de formation différentes.

En début d’atelier, chaque participant est invité à prendre connaissance des données brutes, recueillies par PJ durant leur module d’évaluation. Ensuite, individuellement, chacun a inscrit, sur des post-it, quatre éléments qui lui semblaient répondre à la question évaluative. Les participants ont ensuite expliqué leurs choix et procédé à des regroupements d’idées. C’est au travers de ces processus d’explicitation et de catégorisation qu’émergent une série d’objets sur lesquels on souhaite faire porter l’évaluation : les ressources et outils, l’évolution des pratiques professionnelles de l’équipe, la posture professionnelle, l’évolution des représentations, la formalisation, la mise en pratique, le processus de formation et les savoirs. Chaque objet a été détaillé et enrichi d’informations directement issues des données de départ. Cette catégorisation est représentée dans la mindmap. On y voit apparaître, sous chaque objet, les éléments retenus qui préfigurent les critères d’évaluation. Les flèches montrent les liens causaux voire temporels entre les catégories d’objets, qui s’enchainent logiquement ou se renforcent mutuellement.

Définir des critères et des indicateurs utiles et réalistes

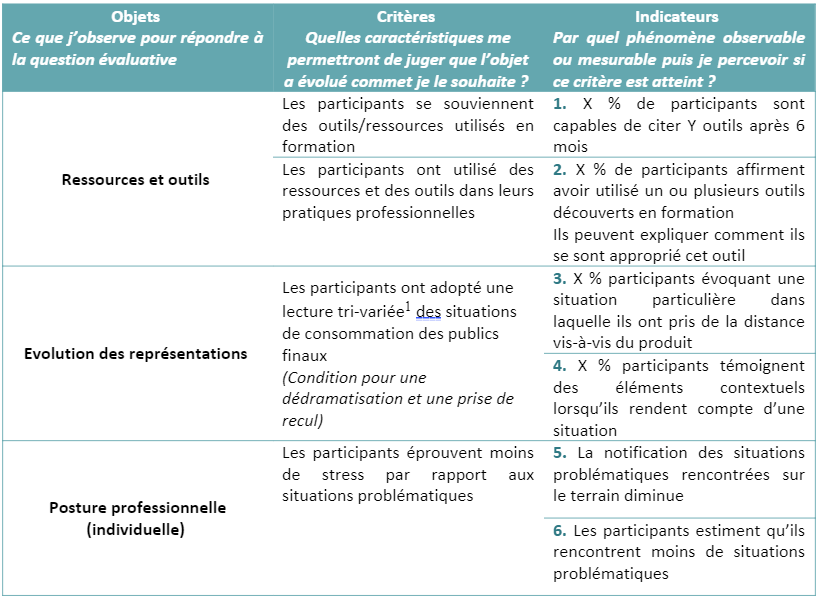

Quelques semaines plus tard, l’exercice a été poursuivi au départ de la mindmap, plus particulièrement, sur deux objets d’évaluation ; les « ressources et outils » et la « posture professionnelle individuelle ».

La connaissance du contexte de la formation par PJ et l’œil extérieur apporté par les participants ont permis d’affiner progressivement la vision des objets pour aboutir à des critères et des indicateurs. C’est la confrontation des points de vue ainsi que les allers et retours dans la réflexion qui permettent d’aboutir à des indicateurs pertinents et réalistes.

Dans une démarche d’évaluation pleinement participative et négociée, les professionnels formés par PJ pourraient – pourquoi pas – se voir impliqués de la sorte dans la définition et la négociation des critères et indicateurs d’évaluation.

Les critères sont précisés au départ des contenus évoqués durant la première séance et rassemblés sous chacun des objets de la mindmap. Les indicateurs sont choisis en fonction de leur utilité, de leur faisabilité, de leur proximité avec la réalité étudiée. Les indicateurs proposés ici devraient encore être affinés en définissant quel est le seuil, la proportion à partir de laquelle on jugera que la formation est pertinente ou au contraire doit être revue ; on peut aussi observer la progression des indicateurs au fur et à mesure que l’on adapte les formations.

Pour répondre à la question « La formation a-t-elle eu un effet sur les ressources mobilisées par les participants », deux critères complémentaires ont été investigués. L’un d’entre eux est le souvenir des outils présentés lors de la formation, avec pour indicateur : la proportion des participants citant une majeure partie des outils. L’autre critère est l’utilisation des outils dans la pratique avec pour indicateur : la proportion des participants ayant utilisé un ou plusieurs outils six mois après la formation. Ce dernier indicateur peut être complété qualitativement par une description des modalités d’utilisation et d’appropriation de cet outil en contexte.

Pour répondre à la question « la formation a-t-elle eu un effet sur la posture professionnelle de participants », on passe par un critère intermédiaire fondamental pour PJ : la lecture tri-variée des situations de consommation. Cette approche implique de concevoir les consommations comme la résultante d’une combinaison d’éléments de contexte, de facteurs individuels et de caractéristiques du produit consommé. Pour permettre aux professionnels de prendre du recul par rapport aux situations de consommation, d’atténuer leur vision problématique de celles-ci et de diminuer leur stress face à de telles situations (objet : posture), il importerait donc de passer par une évolution de ces représentations (objet : représentations). En conséquence, deux indicateurs sont retenus en lien avec l’évolution de la posture et deux indicateurs en lien avec l‘évolution des représentations.

Les grains de sable essentiels

La formation donnée par PJ implique un double niveau d’intervention. Les dimensions collectives et individuelles interviennent et sont fondamentales dans la compréhension du contexte de l’évaluation. Le matériau brut ne permet pas toujours d’identifier clairement si les personnes parlent en leur nom ou au nom de leur équipe. Certes le matériau n’est pas parfait, mais il existe et permet à PJ de se questionner et d’envisager l’évolution du dispositif d’évaluation à 6 mois.

La temporalité du dispositif d’évaluation à 6 mois a été un élément essentiel dans la définition des critères et des indicateurs. Spontanément, dans l’exercice, les participants citent des propositions qui relèvent davantage d’une évaluation au sortir de la formation plutôt que d’une évaluation à 6 mois. Dès lors, il importe de bien questionner la pertinence de chaque critère en regard de cette dimension temporelle.

Ce dispositif d’évaluation à 6 mois illustre la maigre frontière entre évaluation formative et sommative. En effet, PJ endosse à la fois la casquette de formateur et celle d’évaluateur. Au-delà de l’évaluation, il s’agit de continuer à former, de renforcer les acquis et de favoriser leur transfert dans la pratique, de créer de la cohésion au sein de l’équipe formée. De plus, ce dispositif est intégré dès le départ dans l’offre de formation, en ce sens qu’il se déploie dans la continuité de l’apprentissage.

Perspectives pour les séminaires « Evaluation » de ESPRIst-ULiège

Le format de ce séminaire semble avoir été particulièrement formateur pour les participants. Enclencher la réflexion collective sur un projet d’évaluation en pleine construction est vécu comme une démarche motivante. Ce séminaire a suscité de nombreux échanges entre professionnels amenant une diversité de perspectives dans l’évaluation.

De plus, la démarche proposée pour les exercices se voulait intuitive et transférable au sein des équipes. Certains y ont vu la possibilité de mener une réflexion en interne sur les dispositifs d’évaluation (de formation ou autres) et de transposer l’exercice dans leur structure en impliquant leurs collègues ou en les accompagnant dans le processus de co-construction. Certains ont découvert la possibilité d’identifier les objets d’évaluation au départ de données brutes en se distançant des modèles théoriques.

Au terme de ce séminaire, les participants ont toutefois voulu partager une inquiétude. Si de telles pratiques d’évaluation font sens pour les professionnels, ceux-ci redoutent qu’elles soient peu valorisées par les pouvoirs subsidiants. Comment construire un langage commun avec ces derniers ? Est-il possible d’adopter un référentiel d’évaluation commun qui rencontre aussi leurs contraintes ?

Vous aussi, vous souhaitez partager vos expériences et interrogations sur l’évaluation ?

En 2021, une des rencontres sera consacrée à l’évaluation du partenariat. Si vous souhaitez être impliqué dans la préparation de celle-ci, contactez l’équipe ESPRIst-ULiège par mail esprist.appui@uliege.be

(1) Lecture qui met en relation trois variables